Generative KI mit unternehmensinternen Daten richtig nutzen

Datenmengen aus Dokumenten auszulesen und gezielt Fragen zu stellen, wird mit Künstlicher Intelligenz (KI) komfortabel, meint Gerald Martinetz, Verantwortlicher für die Bereiche angewandte künstliche Intelligenz und Klassifizierung bei Mindbreeze. Im Gastkommentar erklärt er, wie das funktioniert.

Methoden der generativen Künstlichen Intelligenz (KI) verändern den Umgang mit großen Datenmengen. Anstatt umfangreiche Studien, beispielsweise über die Auswirkungen des Klimawandels, langwierig auszuwerten, sind Large Language Models (LLM) in der Lage etwa Informationen zu Niederschlagsmustern, Infrastruktur sowie städtischen Wachstum aus den vorhandenen Daten zu extrahieren und eine Zusammenfassung zu erstellen.

Anzeige

Das derzeit bekannteste Large Language Model (LLM) ist GPT, die Basis der öffentlich zugänglichen KI-Anwendung ChatGPT. Um mit diesen Tools jedoch echten Mehrwert im Unternehmenseinsatz zu schaffen, ist der Zugriff auf interne Informationen unerlässlich. Dabei ist es wichtig, dass der Einsatz von LLMs nicht nur effizient, sondern auch im Einklang mit den Datenschutz- und Compliance-Vorgaben erfolgt. Versicherungsunternehmen sollten deshalb auf den innovativen „Retrieval Augmented Generation“-Ansatz (RAG) setzen, der es ihnen ermöglicht, generative KI zu nutzen, ohne geltende gesetzliche Anforderungen zu missachten.

Retrieval Augmented Generation

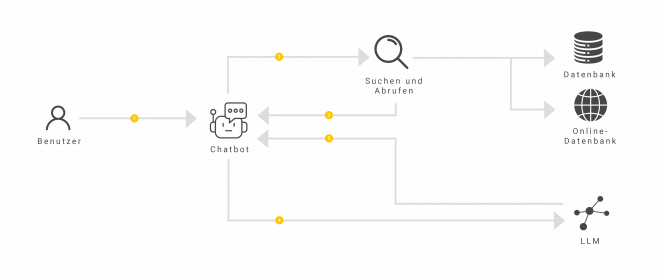

Durch Retrieval Augmented Generation (RAG) generieren LLMs ihre Antworten aus internen Unternehmensdaten, indem sie eine Kombination aus Abruf- (Retrieval) und Generationsfähigkeiten nutzen.

Insight Engines sind spezialisierte Softwarelösungen, die beim RAG-Ansatz dem LLM die internen Fakten für die Antwortgenerierung zur Verfügung stellen. Dafür analysieren sie große Datenmengen aus unterschiedlichsten Quellen, wie Unternehmensdatenbanken, Dokumentenarchiven, E-Mails und sogar extern angebundenen Datenquellen. Mittels sogenannten „Konnektoren“ bindet das Unternehmen jene Quellen an, die die Insight Engine durchsuchen soll. Dabei ist es egal, ob sich die Daten auf eigenen Servern im Haus (on-premises), in einem Datencenter (SaaS-Umgebung) oder in einem Marketplace wie Microsoft Azure befinden. Bei der Analyse der Daten verbleiben diese stets an ihrem ursprünglichen Ort, werden nicht zwischengespeichert, oder an Dritte weitergegeben.

Durch den RAG-Ansatz verbessert das LLM auch die Genauigkeit der generierten Inhalte, indem sowohl das abgerufene Wissen als auch die zuvor generierten Antworten berücksichtigt werden.

Kurz gesagt, eine Insight Engine liefert die relevanten unternehmensinternen Fakten, aus denen das LLM textuelle Antworten generiert.

Effiziente Analyse von Studien und Chatten mit Dokumenten durch Retrieval Augmented Generation

Sehen wir uns das Beispiel über die Studie zu den Auswirkungen des Klimawandels auf Hochwasserrisiken noch mal genauer an: Die Insight Engine führt bei diesem Beispiel die internen Datensätze über Niederschlagsmustern, Infrastruktur sowie städtischen Wachstum im Hintergrund zusammen, extrahiert die relevanten Informationen und übergibt sie dem LLM. Das LLM formuliert daraufhin eine Vorhersage genau aus jenen Daten.

Zudem ist es durch diese Technologie-Kombination möglich, sich direkt mit Dokumenten zu unterhalten, genauer gesagt diesen Fragen zu stellen. Wie bei ChatGPT geben Nutzer:innen ihre Fragen in ein Chatfenster ein, woraufhin die Insight Engine die relevanten Fakten aus dem Dokument extrahiert und das LLM mithilfe dieser Fakten die Frage beantwortet.

Das „Chatten“ mit Dokumenten ist vorwiegend bei großen Dokumenten komfortabel, da ein mühsames Suchen entfällt.

Anzeige

Die Vorteile von Retrieval Augmented zusammengefasst

Beim RAG-Ansatz verbindet eine Insight Engine generative KI-Modelle mit internen Datenquellen und ermöglicht Versicherungsunternehmen dadurch eine präzisere und effizientere Informationsauswertung. Ein wesentlicher Vorteil besteht darin, dass sensible Daten im Unternehmen verbleiben, was die Einhaltung von Datenschutzvorgaben gewährleistet. Durch die Kombination von unternehmensspezifischem Wissen mit der leistungsstarken Fähigkeit eines LLMs können faktengestützte und schnelle Antworten auf komplexe Fragen geliefert werden. Dies beschleunigt die Entscheidungsfindung und ermöglicht es Versicherungsunternehmen, sich im dynamischen Marktumfeld flexibel und wettbewerbsfähig zu positionieren.