Big Data: Versicherer auf Schatzsuche

Das allgegenwärtige Hypethema „Big Data“ beschäftigt zunehmend auch die Assekuranz. Doch gerade die Finanzwirtschaft steht dabei noch ganz am Anfang. Die Branche steht zunächst vor der Aufgabe, ihre „Small“ Data in den Griff zu bekommen und die vorhandenen Business Intelligence (BI)-Lösungen wirkungsvoll zu nutzen. Trotz aller Euphorie hat das Big-Data-Zeitalter in der Versicherungsbranche in Deutschland noch nicht wirklich begonnen. 58 Prozent der Versicherer und Banken bearbeiten in BI-Lösungen weniger als zehn Terabyte an Daten. Nur vier Prozent verarbeiten in ihren Data Warehouses Datenmengen jenseits der 100-Terabyte-Marke.

- Big Data: Versicherer auf Schatzsuche

- Noch nicht angekommen

Der Traum ist schnell geträumt: Mit Hilfe von IT-Lösungen lässt sich aus Unmengen von Daten die Zukunft vorhersagen. Manager bei Versicherern wissen schon vorher, welcher Versicherte im kommenden Jahr sein Auto zu Schrott fahren oder die Hausratversicherung mit einer hohen Schadensmeldung ausreizen wird. Aus historischen und aktuellen Informationen lässt sich herauslesen, welcher Kunde vermutlich einen Versicherungsbetrug plant. Und mit frischem Input aus Internet und Social Media können Kundenwünsche künftig präziser erfüllt werden, als es die Konkurrenz vermag.

Anzeige

Datenmengen wachsen exponentiell, liegen in vielfältigen Formen vor und müssen in immer kürzeren Zeiträumen analysiert werden, heißt es in den Medien. Die gängigen Definitionen beschreiben Big Data als Methoden und Technologien für die hochskalierbare Erfassung, Speicherung und Analyse polystrukturierter Daten. Es wird deutlich, dass Big Data nicht ausschließlich auf größere Mengen an Daten abzielt (gemessen zum Beispiel in Tera- oder Petabytes), sondern auch auf die Vielfalt der Daten (interne, externe, strukturierte und unstrukturierte Daten) und die extreme Änderungs- und Verfügbarkeitsgeschwindigkeit von Daten (Near- oder Realtime).

Plakative Beispiele aus anderen Branchen, bei denen Unternehmen und Verwaltungen großen Gewinn aus ihren Datenmassen gezogen haben, wecken in der Versicherungsbranche Sehnsüchte. Die Menge an Verkehrsbehinderungen der schwedischen Stadt Stockholm konnte beispielsweise um 20 Prozent reduziert werden, weil jede Sekunde 250.000 Standortdaten von Verkehrsteilnehmern, Video- und Sensorsystemen ausgewertet und zur Verkehrssteuerung eingesetzt werden. Die Ebay-Tochter Paypal nutzt die schnellere Auswertung großer Datenmengen, um Kreditkartenbetrug bereits während des Bezahlvorgangs aufzudecken. Dafür werden verschiedenste Kriterien wie Umsatzhöhe, Nutzungsort, Währung und Zeitpunkt herangezogen, um kriminelle Muster zu erkennen.

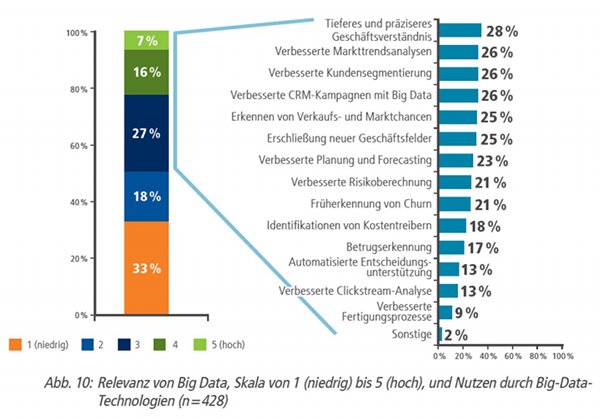

Die Mehrheit der Unternehmen aus der Finanzbranche, die auf Big Data setzen, versprechen sich vor allem ein tieferes Verständnis ihres Geschäfts und ihrer Kunden. Das sind Ergebnisse der Studie „Business Intelligence Maturity Audit (biMA® 2012/13)“ von Steria Mummert Consulting, für die Teilnehmer aus zwanzig europäischen Ländern befragt wurden. 36 Prozent der Führungskräfte aus Versicherungen und Banken erhoffen sich eine verbesserte Kundensegmentierung, 28 Prozent möchten ein tieferes Geschäftsverständnis erreichen und für ebenso viele ist die Betrugserkennung ein wichtiges Big-Data-Thema.

Gerade aus einer vertrieblichen Sicht wird auch immer wieder die 360-Grad-Sicht auf den Kunden erwartet, um mit diesen Erkenntnissen Marketingaktionen individueller zu gestalten. Es fällt auf, dass identische Versprechungen auch mit BI in Verbindung gebracht werden. So ist ja gerade das tiefere und präzisere Geschäftsverständnis die definitorische Grundidee des Begriffs Business Intelligence.

Anzeige

Big Data lässt so manches IT-Unternehmen großes Umsatzpotenzial wittern. In diesem Jahr soll der deutsche Big-Data-Markt auf rund 651 Millionen Euro wachsen, so eine Schätzung des Branchenverbands Bitkom. Das würde eine Steigerung um 85 Prozent gegenüber 2012 bedeuten. Bis 2016 soll das Volumen auf fast 1,7 Milliarden Euro anschwellen.

Noch nicht angekommen

Bei aller Euphorie für das Thema hat das Big-Data-Zeitalter bei der Assekuranz in Deutschland noch nicht wirklich begonnen. 58 Prozent der Finanzunternehmen bearbeiten in BI-Lösungen weniger als zehn Terabyte an Daten. Nur vier Prozent verarbeiten in ihren Data Warehouses Datenmengen jenseits der 100-Terabyte-Marke.

Auch die verantwortlichen Manager sehen den Nutzen noch eher skeptisch. In der Wahrnehmung der Versicherungsentscheider erreicht der Trend Big Data nicht einmal eine mittlere Relevanz (2,11 von möglichen 5 Punkten). Flexible Werkzeuge für schnelle, individuelle Analysen (Self-Service-BI), klare Regelwerke und Definitionen (BI-Governance) und die stärkere Verzahnung von Business Intelligence und Tagesgeschäft (Operational BI) bewerten sie als deutlich wichtiger. Erstaunliche 44 Prozent der für die biMA-Studie befragten Entscheider aus Versicherungen und Banken stimmen der These zu, Big Data verfüge über keinen zusätzlichen Nutzen, da es sich lediglich um ein Hypethema handele. Im Schnitt aller Branchen sind nur 26 Prozent dieser Meinung.

Anzeige

Auch die oftmals als Paradebeispiel für mögliche Big-Data-Analysen genannten Informationen aus sozialen Medien spielen noch keine wirklich große Rolle für Versicherer. Die gefühlte Allgegenwärtigkeit von sozialen Medien im privaten Umfeld wird häufig eins-zu-eins auf Geschäftsbereiche projiziert. Zwar sind 75 Prozent der von Steria Mummert Consulting für die Studie „Nachhaltige Wertschöpfung“ befragten Versicherer bei Facebook aktiv, ein Viertel bei Twitter und immerhin noch 13 Prozent bei Youtube. Doch die Aktivität bei deren Facebook-Auftritten fällt bisher noch nicht üppig aus. Im Durchschnitt fiel 2011 nur rund ein inhaltlicher Beitrag, ein so genannter Post, pro Tag und Seite an: Selbst der Spitzenreiter der Studie, die R+V Versicherung, hatte nur 801 Posts im ganzen Jahr, der Branchenprimus Allianz Deutschland 285 Posts. Daher werden BI-Systeme noch selten für die Auswertung von Social Media genutzt.

Für das geringe Aufkommen in den Social Media und den wenigen hier vorhandenen Daten sind Big-Data-Instrumente noch wenig sinnvoll. Daher stufen Versicherungsmanager die Relevanz des Themas „SocialMedia-Analyse“ gerade einmal mit einer 1,61 von möglichen 5 Punkten ein. Damit landet es auf dem vorletzten Platz aller 15 abgefragten BI-Trendthemen. Ganz oben stehen hingegen Operational BI, BI Governance und Self-Service-BI.

Versicherer verrennen sich

Geblendet von der Angst, einen wichtigen Trend zu verpassen und Möglichkeiten nicht auszuschöpfen, ist Big Data immer häufiger Thema in den Chefetagen. Dabei stehen sich die Versicherer aber vielfach selbst im Weg. Projekte werden zwar schnell losgetreten. Doch diesen Projekten fehlt oftmals die wohlüberlegte strategische Basis. Die Verheißungen des Modebegriffs Big Data verführen dazu, schnell in komplexe Technologiediskussion abzudriften, ohne vorher die wichtigsten Fragen zu stellen: Was ist unser Ziel? Was möchten wir mit den Informationen anfangen? Wie sieht der konkrete Big-Data-Anwendungsfall aus?

Der fehlende oder unvollständige Anwendungsnutzen führt im Laufe der Projekte zu großer Ernüchterung hinsichtlich der vermeintlichen Wundertechnologie, die derzeit unter dem Label Big Data vertrieben wird. Ganze 44 Prozent aller Big-Data-Projekte werden daher nicht zu Ende geführt, meldet die texanische Beratungsfirma Infochimps. Technologie kann strategische Entscheidungen nicht ersetzen. Trotzdem unterliegen manche Unternehmen dem Irrglauben, sie müssten vorher nicht so genau wissen, wonach sie suchen, Big-Data-Technologie würde das Problem schon irgendwie lösen.

Hürden überwinden

Vorsicht ist also geboten, wenn die Hoffnungen hinter einem neuen Big-Data-Projekt allzu groß sind. Schließlich muss man sich fragen, ob die bestehenden Daten überhaupt schon hinreichend genutzt werden. Denn schon bisherige BI-Verheißungen wurden zum Teil nicht eingelöst. So liefern die über Jahre durch dezentral initiierte BI-Projekte gewachsenen BI-Lösungen häufig nicht den ursprünglich adressierten Nutzen zur Entscheidungsunterstützung, weil trotz allem keine performanten, konsistenten und qualitativ hochwertigen Informationen vorliegen. Fragmentierte Informationssilos, heterogene Architekturen, uneinheitlich definierte Kennzahlen und Auswertungsobjekte aber insbesondere auch fachliche und technische Intransparenz bezüglich Qualität, Verarbeitung und Herkunft der Daten sind nach wie vor Charakteristika, die viele BI-Landschaften auch bei Versicherern beschreiben.

Die Herausforderung schlechthin im BI-Bereich stellt die Datenqualität dar. BI-Projekte scheitern oft an mangelnder Datenqualität. Für 42 Prozent der Versicherungsentscheider ist sie die größte Herausforderung für BI-Projekte. Ein Beispiel sind Personalabteilungen, die aufgrund von redundanten und uneinheitlichen Daten oftmals nicht berichtsfähig sind. 47 Prozent der befragten Unternehmen sind mit der Datenqualität im Personalbereich unzufrieden. Ein Grund dafür ist der noch immer hohe Anteil an manueller und nicht standardisierter Datenintegration, die fehleranfällig ist. Ungenügendes Datenmanagement, mangelnde Standardisierung und Industrialisierung verhindern stabile, flexible und skalierbare Daten. Wenn Assekuranzen schon ihre bisherigen BI-Systeme nicht im Griff haben, sollten sie sich nicht unüberlegt in ein neues BI-Projekt stürzen.

Der menschliche Faktor

Schließlich ergeben sich aus den nicht vollständig eingelösten Verheißungen der BI der Vergangenheit vielfach auch erhebliche Herausforderungen, die zukünftigen Anwender zu begeistern. Die Informationssilos der Versicherer haben als Gesamtlösung in den Augen der Endanwender häufig über die Jahre die notwendige Akzeptanz verloren. So sinkt die Bereitschaft, in weiteren BI-Projekten oder gar Big-Data-Vorhaben mitzuwirken. Im Gegenteil: Aus der Unzufriedenheit heraus entstehen neue isolierte Bypass-Lösungen für weitere spezielle Anwendungsfelder, die die Komplexität und Intransparenz weiter steigern. Für die BI-Verantwortlichen ergibt sich daraus eine besonders herausfordernde Situation: Zeigt der Blick in den Rückspiegel, dass die Versprechen leider nicht immer gehalten werden können, steigt hinsichtlich der Zukunft die Unsicherheit. Bleibt der zu erwartende Tsunami an Informationen beherrschbar? Wie kann die Roadmap vom übertriebenen Hype hin zur nachhaltigen Innovationen gefunden werden?

Fazit

Viele Entscheider in der Versicherungsbranche halten Big Data für ein Hypethema, hinter dem nicht viel steckt. Sie glauben teilweise zu recht, dass die Lösung Big Data ihre Probleme erst noch sucht. Denn Versicherer werten ihre Kundendaten schon seit Jahrzehnten aus und versinken nicht selten bereits in „Small“ Data.

Um in Zukunft neben Small auch Big Data gerecht zu werden, müssen Versicherer neue Denkmuster lernen. Die Versicherer-IT braucht ein neues analytisches Ökosystem, das aus flexiblen Elementen besteht, die bei definierten Freiheitsgraden miteinander agieren. BI-Systeme müssen sich demzufolge in der Zukunft von starren und zentralistischen Strukturen und IT-Architekturen lösen. Durch stärkere Standardisierung und Industrialisierung und einen dezentralen Ansatz muss ein Ausgleich zwischen konkurrierenden Zielen wie Flexibilität und Agilität auf der einen und Qualität und Effizienz auf der anderen Seite geschaffen werden. BI-Systeme der Zukunft werden mit vielen optionalen Komponenten zur Verfügung gestellt werden, die zum Beispiel jeweilige Big-Data-Anwendungsfälle durchaus auch nur für einen beschränkten zeitlichen Zeitraum unterstützen. Die einzelnen Komponenten bieten bestimmte Leistungen zur Datenbereitstellung und -analyse in Form definierter Services an. Je nachdem, was ein Anwender vorhat, stellt er eine Lösung durch eine Kombination dieser Services zusammen. Das bedingt eine definierte technische Heterogenität mit unterschiedlichen Speicher-, Integrations- und Analysetechnologien. Doch der Weg zu diesem „Analytical Ecosystem of the Future“ ist noch lang und nur mit vielen kleinen Umbauschritten zu erreichen.

Autoren: Klaus-Dieter Schulze, Dr. Carsten Dittmar und Volker Oßendoth von Steria Mummert Consulting

Anzeige

Hintergrund:

Die Studie „biMA®2012/13“ (Business Intelligence Maturity Audit) wurde nach den Jahren 2004, 2006 und 2009 nun bereits zum vierten Mal durchgeführt. Dabei kommen die Teilnehmer erstmals nicht nur aus dem deutschsprachigen Raum, sondern aus 20 europäischen Ländern. Mit mehr als 650 Teilnehmern gehört die Studie zu einer der größten Analysen zum Thema Business Intelligence in Europa. Die methodische Basis bilden das von Steria Mummert Consulting entwickelte BI-spezifische Reifegradmodell Business Intelligence Maturity Model (biMM®) sowie die darauf aufbauende Analysemethode Business Intelligence Maturity Audit (biMA®).

- Big Data: Versicherer auf Schatzsuche

- Noch nicht angekommen